图像去雾领域数据集

图像去雾领域数据集

图像去雾领域中真实配对数据集的拍摄具有严格的时间和天气要求,需要在同一机位下分别拍摄雾霾天气下以及无雾天气下的图片组成成对的真实样本,其获取具有以下问题:

- 样本的采集受到限制,只能在有雾的天气条件下拍摄数据样本。

- 成对样本获取的时间间隔较长,与雾图像对应的清晰图像(GT)需要天气由雾转晴后才能继续拍摄。

- 由于间隔的时间较长,场景中的物体大概率会发生变化,去雾真实数据集相较其他真实增强数据集(如阴影去除、低光照增强等)有更严重的样本不对齐问题。

- 由于间隔的时间较长,场景中的光照条件会发生变化,难以保证拍摄清晰图像时的光照条件与雾图像原始光照条件相同,导致训练深度学习模型恢复的并不是雾图像的原始的光照。

因此图像去雾领域的数据集的获取主要有以下两种主流方式:

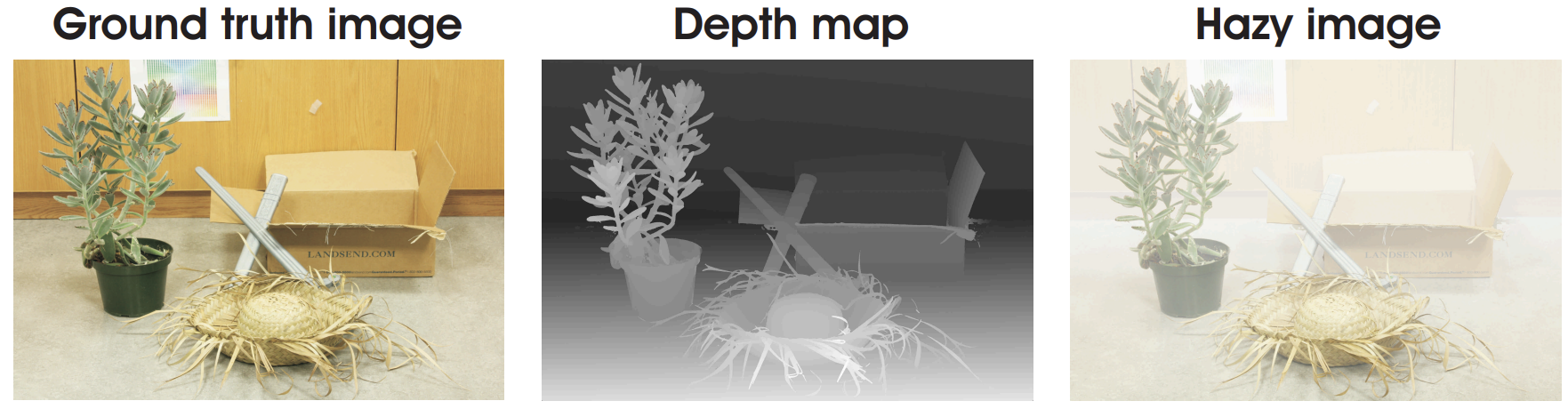

- 合成数据集:通过在清晰图像上人工加雾的方式取得雾图像-清晰图像数据对。加雾的方式通常是利用

大气散射模型(去雾领域经典物理建模),使用清晰图像的深度图作为场景的透射率,代入大气散射模型中并调整参数,以获取不同浓度的加雾图像。- 优点:

- 可以以较低的成本获取大规模的训练样本。

- 合成样本非常精确,不存在不对齐问题。

- 缺点:

- 通过物理模型加雾,深度学习很容易学习的物理模型加雾的逆向过程而不是学习真正的去雾,且物理模型自身也存在缺陷。

- 透射率(即雾的浓度分布信息)由场景深度信息决定,这表明合成雾图像中的雾是在场景中均匀分布的,图片上的浓度只与图片深度有关,不能模拟真实更加复杂的随机分布的特征。

- 优点:

- 真实数据集:使用雾生成设备

人工造雾,从而摆脱天气条件的限制、减少成对样本拍摄的时间间隔。- 优点:

- 相比合成数据集,真实数据集中雾的特征更加多样且复杂,更具有挑战性。

- 缺点:

- 仍然有不对齐的问题。

- 人工生成的雾更像”烟“而不是”雾“。

- 现有真实数据集数据规模要远小于合成数据集

- 优点:

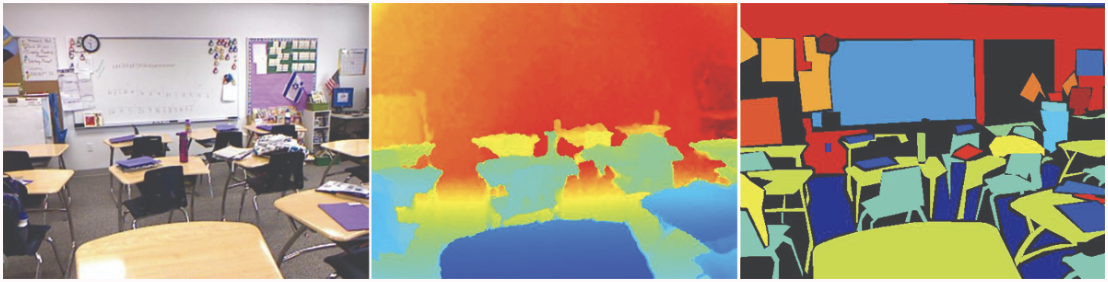

NYUv2 (NYU-Depth V2)

纽约大学创建,由 Kinect(3D体感摄像机)的 RGB 和 Depth 摄像头记录的各种室内场景的视频序列组成。

- 包含1449对RGB图像及其对应的深度图。

- 摄于3个城市的464个场景。

- 407,024个未标记的帧。

- 数据集中包含以下部分:

- 标记数据:经过预处理的带标签的数据(原始数据的子集)。

- 原始数据:Kinect提供的原始RGB、深度和加速数据。

- 工具箱:用于操作数据和标签的工具。

由于数据集中包含深度信息,常被应用于雾图像的合成。研究者通过设置不同的大气光参数和透射率参数,由大气散射模型合成雾图像数据集。

D-HAZY

- 是最早提出的一个专门用于定量评估图像去雾的数据集。

- 包含1400多对清晰图像和对应的深度图。这些数据来自于 Middelbury 数据集和 NYU-Depth V2 数据集。

- D-hazy 雾霾数据集采用大气散射模型合成,其中深度信息已知,透射率中参数 $\beta$ 设置为1,大气光值也被设置为1。

HazeRD

- 是在 14 个室外环境拍摄的清晰图像上合成数据集。

- 标注样本包括一幅无雾 RGB 图像和一个对应深度图。

- 每个场景通过设置不同透射率参数 $\beta$ 合成 5 种从轻雾到浓雾图像,模拟不同天气条件的雾霾。其中,大气光值设置为 0.76,以确保在阴天物体清晰度。

- 提供了一个MATLAB函数,可以根据大气散射模型生成不同雾霾参数的雾霾图像。

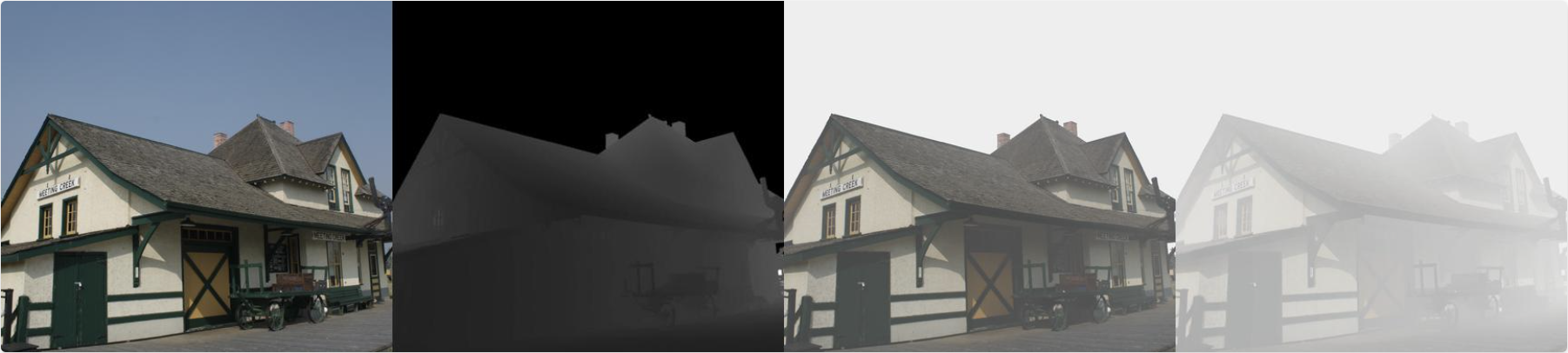

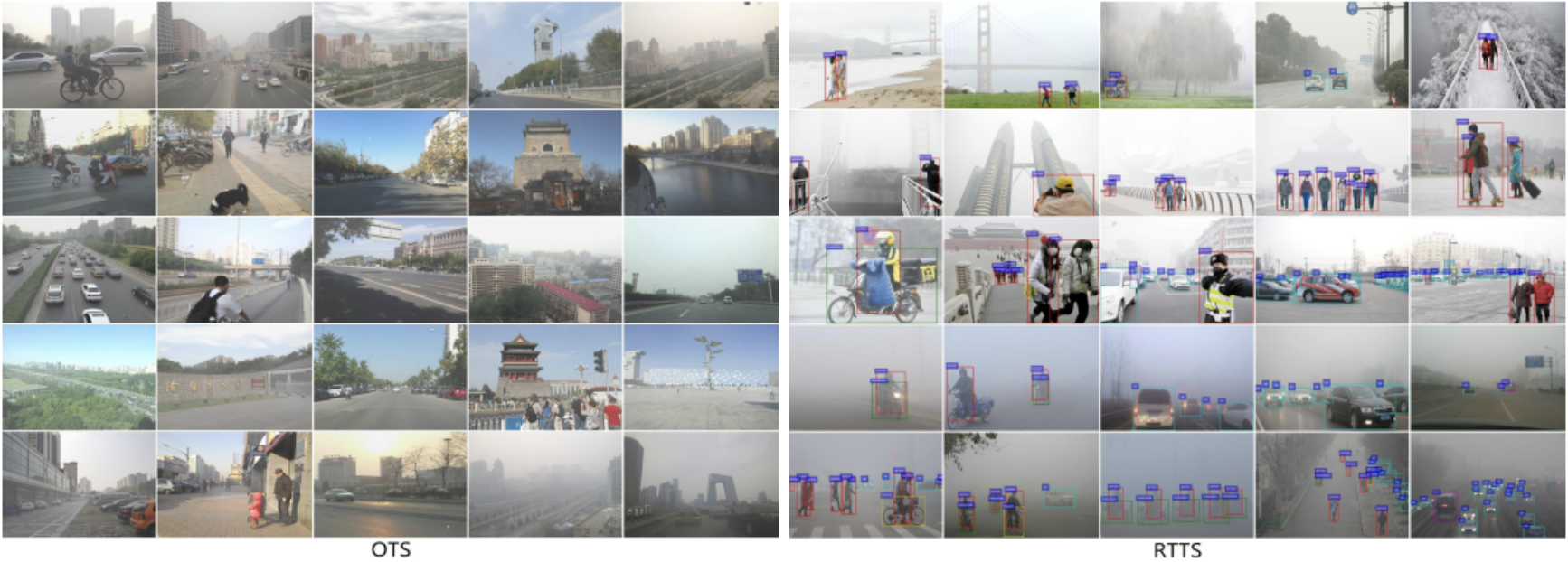

RESIDE

- 是一个大规模人工合成数据集。也是目前最有影响力的合成雾数据集。

- 既使用了 Middelbury 数据集和 NYU-Depth V2 数据集中的清晰图像和深度图生成配对的雾图像,也包含一些由真实图像组成的不配对图像。

- 由每个清晰图像生成 10 幅模糊图像。大气光值取值范围为[0.7, 1.0]之间,透射率中$t(x)=e^{-\beta d(x)}$参数 $\beta$ 取值为[0.6, 1.8]。

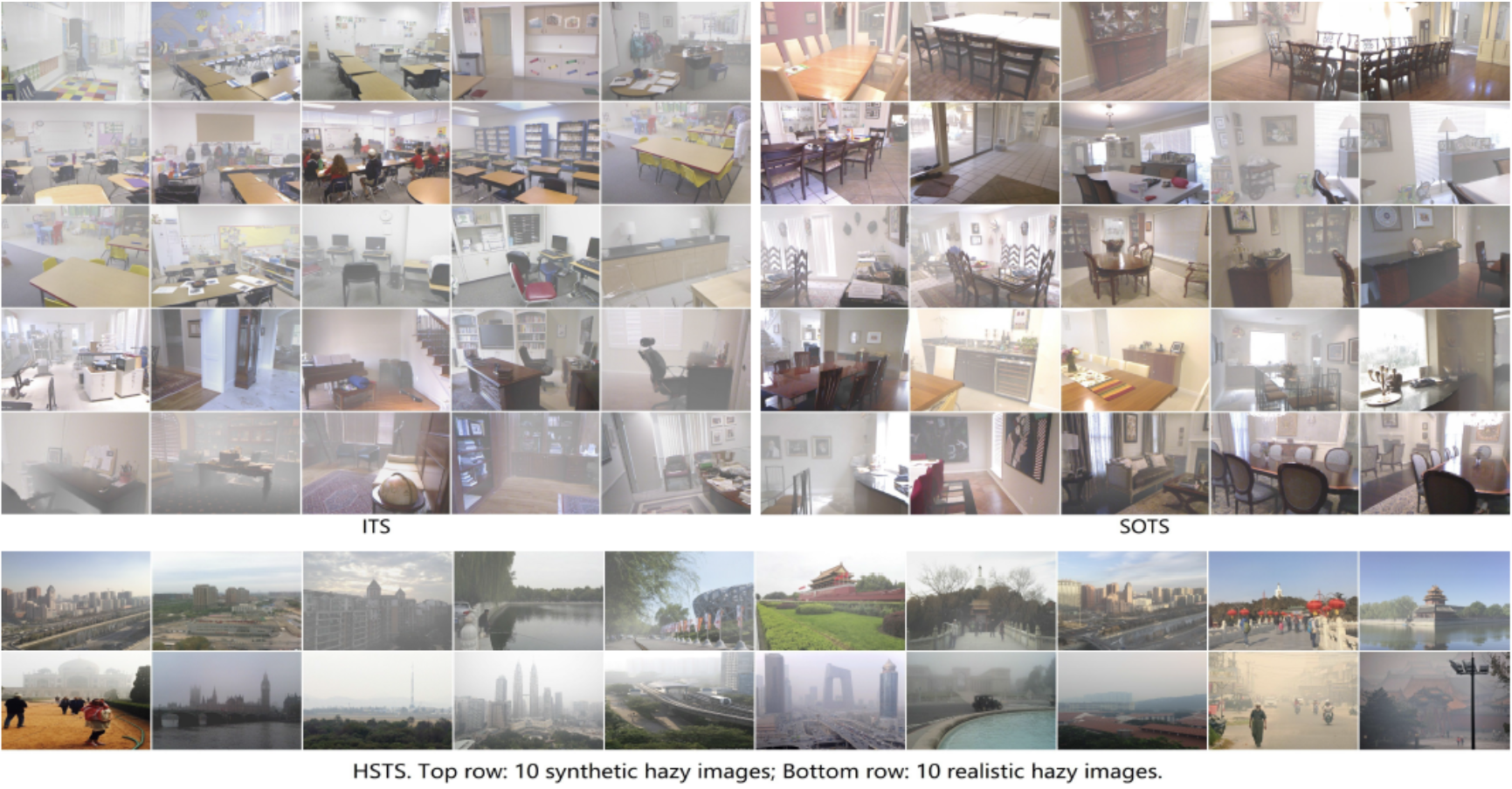

- 数据集标准版(RESIDE-Standard)分为以下子集:

- ITS(Indoor Training Set):用于训练的13990对室内合成图像。

- SOTS (Synthetic Objective Testing Set):用于测试的500对室内合成图像。

- HSTS (Hybrid Subjective Testing Set):用于测试的不配对的10张合成图像和10张真实雾图像。

- 数据集$\beta$版(RESIDE- $\beta$ )是对原数据集的扩充,分为以下子集:

- OTS (Outdoor Training Set):用于训练的72135对室外合成图像。

- RTTS (Real-world Task-Driven Testing Set):用于测试的4322 张真实世界任务驱动测试图像。

- 以及部分未标注的真实世界雾图像。

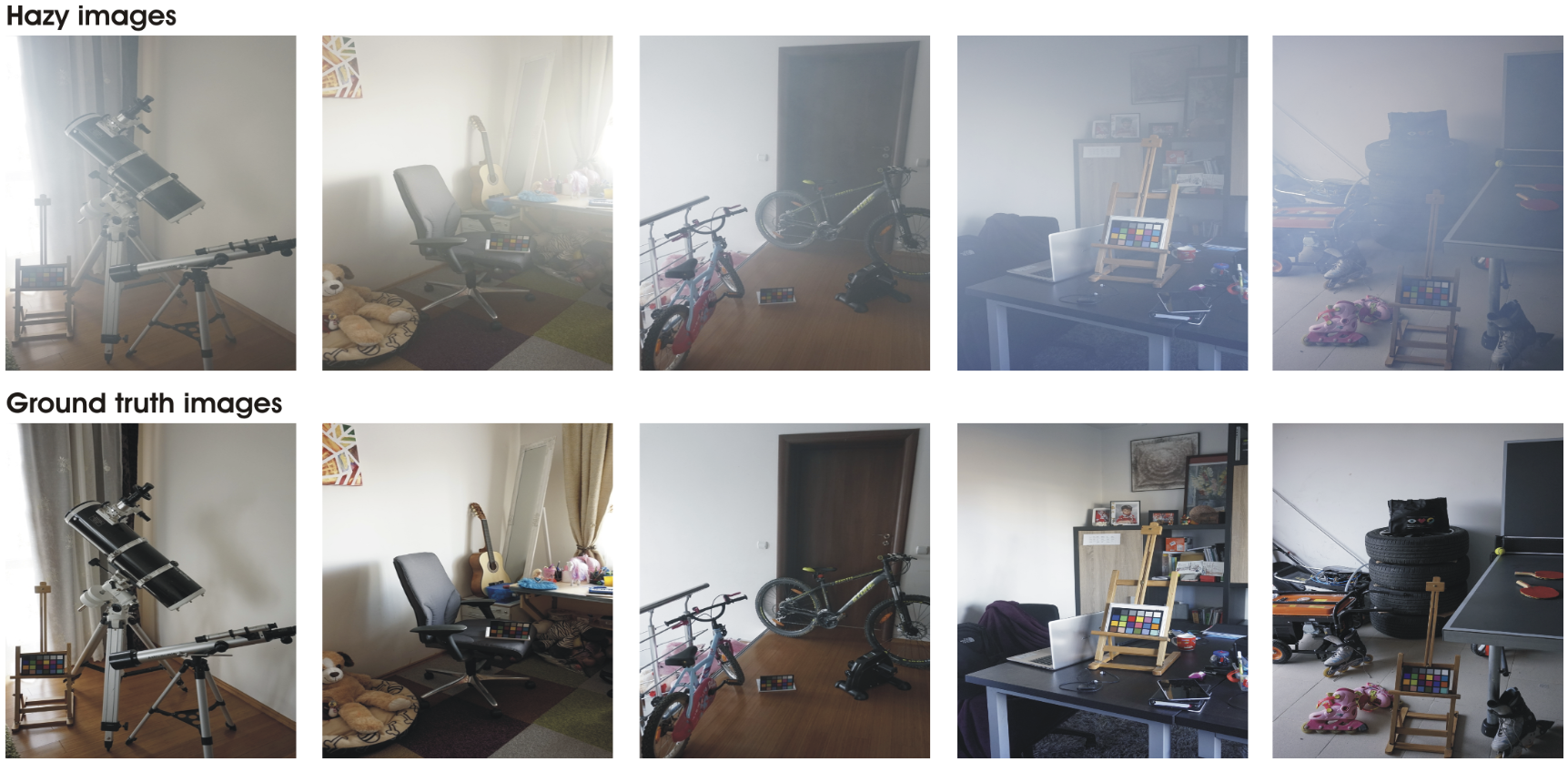

I-HAZE 和 O-HAZE

- O-HAZE 数据集是第一个创建的包含雾/清晰图像对的真实雾数据集。它由 45 对不同的户外场景拍摄的图像组成,使用机器人工造雾的方式生成雾并拍摄雾图像。

- I-HAZE 与 O-HAZE 相似,但采集的是室内环境下的 35 对雾/清晰样本。

- 2018 年 IEEE CVPR NTIRE(New Trends in Image Restoration and Enhancement)研讨会举办针对

真实雾场景的目标检测挑战赛。I-HAZE 和 O-HAZE 被选为挑战赛数据集。

DENSE-HAZE

- 真实图像数据集,用来验证去雾方法在浓雾环境下的表现,数据集中包含 55 对雾/清晰样本。

- 在 2019 年 IEEE CVPR NTIRE 研讨会上, DENSE-HAZE 被选为

浓雾去除挑战赛标准数据集。

NH-HAZE

- 真实图像数据集,用来验证去雾方法在非均匀雾环境下的表现,数据集中包含 55 对雾/清晰样本。

- 在 2020 年 IEEE CVPR NTIRE 研讨会上, NH-HAZE 被选为

非均匀雾图像去雾挑战赛标准数据集。

NH-HAZE2

- 真实图像数据集,用来验证去雾方法在非均匀雾环境下的表现,是NH-HAZE的扩充,数据集中包含 35 对雾/清晰样本。

- 在 2021 年 IEEE CVPR NTIRE 研讨会上, NH-HAZE2 被选为

非均匀去雾挑战赛标准数据集。- 训练图像(01 至 25)

- 验证图像(26 至 30)(GT尚未公开)

- 测试图像(31 至 35)(GT尚未公开)

HD-NH-HAZE

- 真实图像数据集,用来验证去雾方法在高清+非均匀雾环境下的表现,数据集中包含 50 对雾/清晰样本(4000×6000)。

- 在 2023 年 IEEE CVPR NTIRE 研讨会上, HD-NH-HAZE 被选为

高清非均匀去雾挑战赛标准数据集。- 训练图像(01 至 40)

- 验证图像(41 至 45)(GT尚未公开)

- 测试图像(46 至 50)(GT尚未公开)

DNH-HAZE

- 真实图像数据集,用来验证去雾方法在高清+非均匀+浓雾环境下的表现,数据集中包含 50 对雾/清晰样本(4000×6000)。

- 在 2024 年 IEEE CVPR NTIRE 研讨会上, DNH-HAZE 被选为

高清非均匀浓雾去雾挑战赛标准数据集。- 训练图像(01 至 40)

- 验证图像(41 至 45)(GT尚未公开)

- 测试图像(46 至 50)(GT尚未公开)

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 PlanZ!